참고자료

•

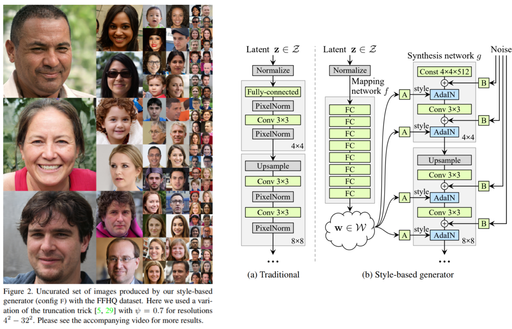

StyleGAN은 PGGAN 구조에서 Style transfer 개념을 적용하여 generator architetcture를 재구성 한 논문입니다. 그로 인하여 PGGAN에서 불가능 했던 style을 scale-specific control이 가능하게 되었습니다.

•

Paper 원문

•

StyleGAN official code(Tensorflow): https://github.com/NVlabs/stylegan

1. Abstract

[제안한 네트워크]Style transfer 문헌에서 차용한 Generative Adversarial Networks을 위한 alternative generator architecture을 제안한다.

[새로운 기능]새로운 아키텍처는 자동으로 학습되고 비지도의 높은 수준의 속성(e.g., pose and identity when trained on human faces)과 생성된 이미지(e.g., 주근깨, 머리카락)의 stochastic variation을 separation하고 직관적으로 scale-specific control이 가능하게 한다.

새로운 generator는 traditional distribution quality metrics 측면에서 SOTA을 향상 시키고 더 나은 interpolation properties을 입증하며 latent factor of variation을 더 잘 disentangled 하게 한다.

interpolation quality와 disentanglement을 정량화(quantify) 하기 위해 모든 generator 아키텍처에 사용할 수 있는 두기자 새로운 자동화된 방법을 제안한다.

[새로운 데이터셋 제공]마지막으로 매우 다양하고 고품질의 human faces 데이터셋을 소개한다.

2.본론

•

고화질 이미지 생성에 적합한 아키텍처를 제안합니다.

◦

예전 기술인 PGGAN 베이스라인 아키텍처의 성능을 향상시켰습니다.

◦

Disentanglement 특성을 향상 시켰습니다. (다양한 특징들이 잘 분리되어있는 걸 의미 더욱 정확하게는 안경 안 쓴 사람을 쓰게 만들 수 있다.)

◦

고해상도 얼굴 데이터셋(FFHQ)를 발표했습니다.

•

예시

•

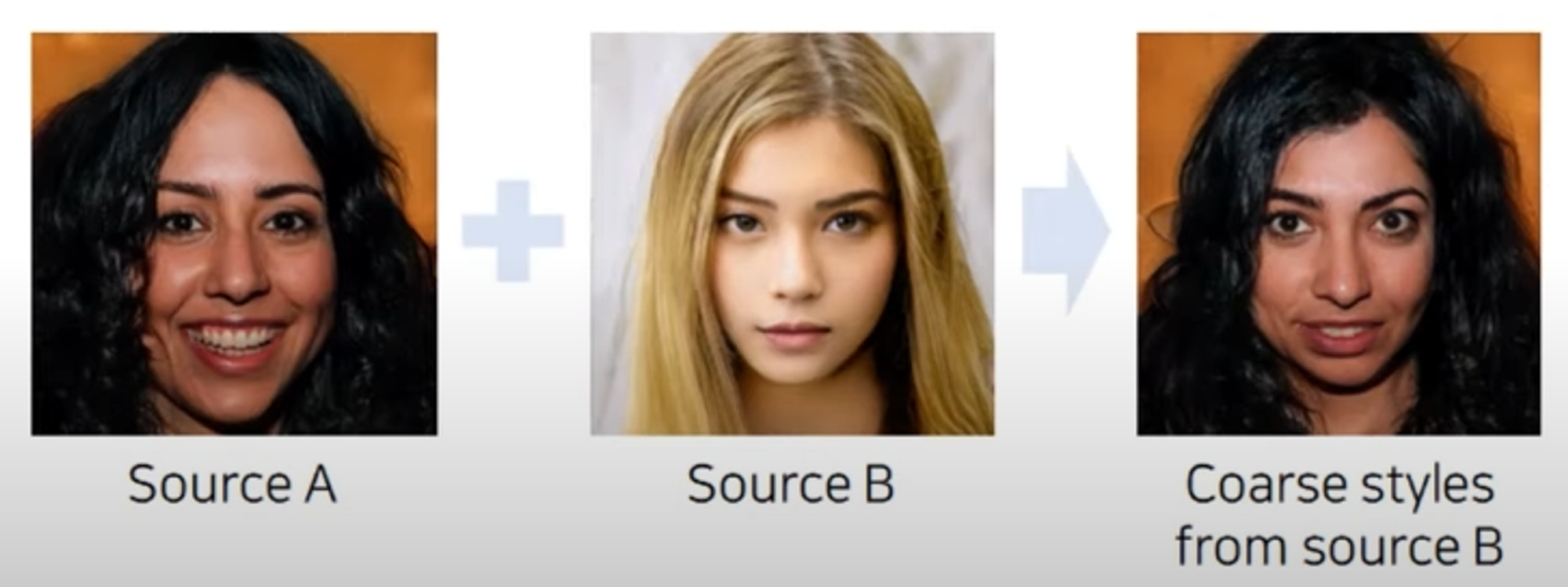

벡터 연산을 통해서 맨 오른쪽에 새로운 이미지를 만들어 낼 수 있다.

•

소스 A와 소스 B의 시멘틱 정보를 합친 결과가 오른쪽이다.

핵심기능 (Mapping Network)

•

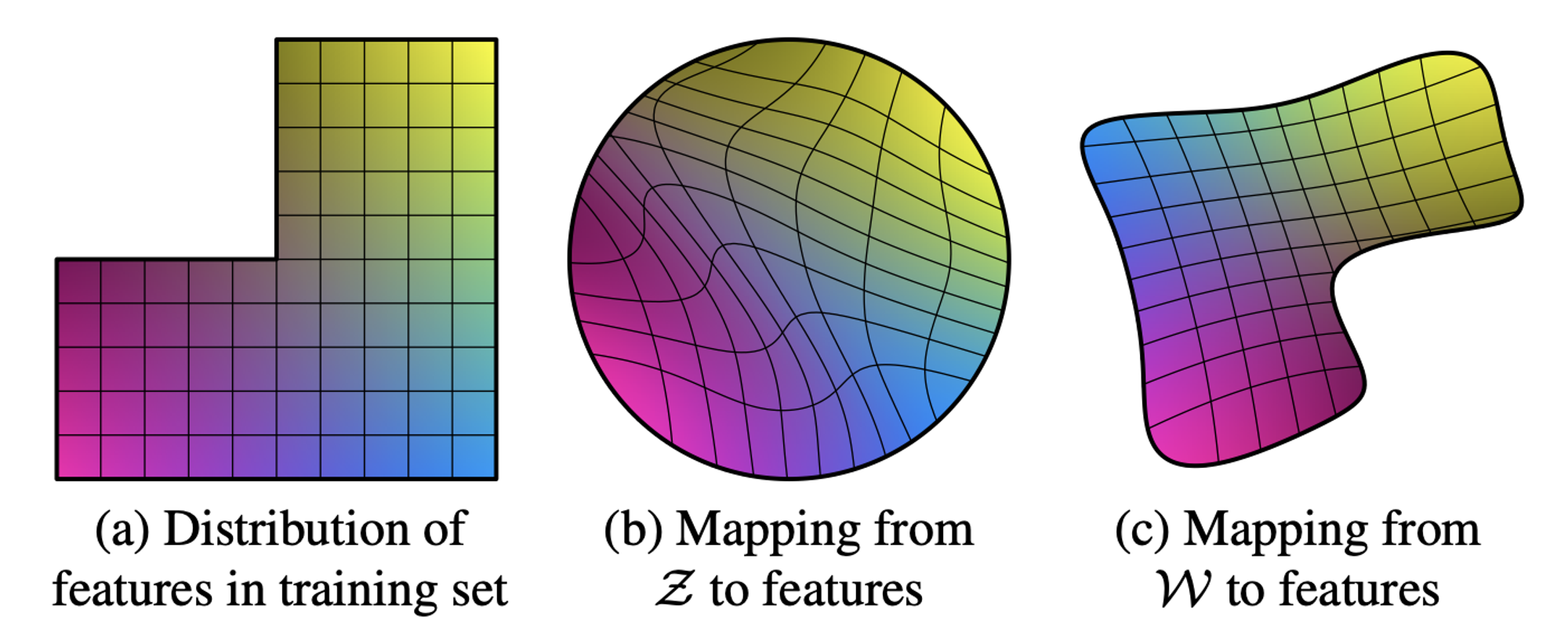

특정 스케일의 벡터를 다른 스케일의 벡토로 메핑 시켜주는 작업이 바로 핵심이다.

Mapping Network를 통해서 나온 \mathcal{W}W는 정확하지는 않지만 학습 데이터셋의 확률 분포와 비슷한 모양으로 우선 mapping이 된 상태이기 때문에 그림 4(c)처럼 특징이 mapping된 latent space의 \mathcal{W}W가 disentangle하게 됩니다.

(그림 4)

안녕하세요

•

한국전자기술연구원 김영광입니다.

•

관련 기술 문의와 R&D 공동 연구 사업 관련 문의는 “glory@keti.re.kr”로 연락 부탁드립니다.

Hello

•

I'm Yeonggwang Kim from the Korea Electronics Research Institute.

•

For technical and business inquiries, please contact me at “glory@keti.re.kr”